Enda vanskeligere å avsløre falske videoer

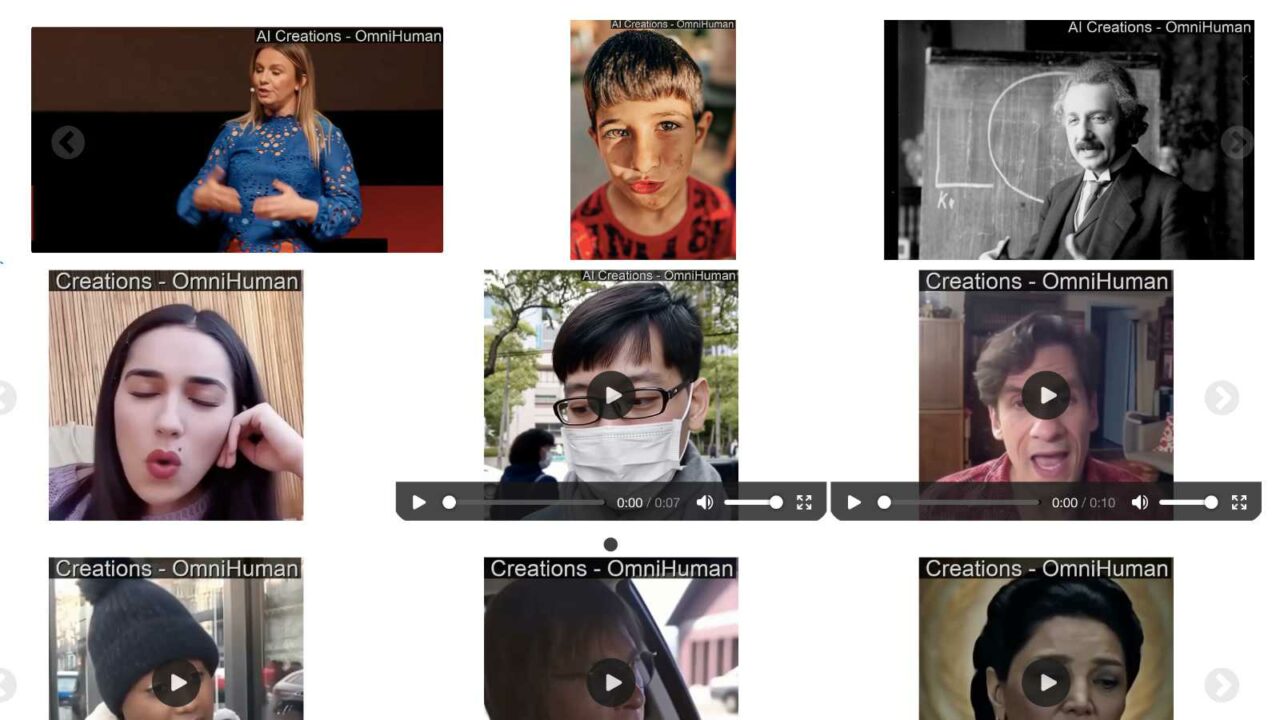

Kunstig intelligens har nå blitt så avansert at det er svært vanskelig å avsløre falske videoer. Bare se på eksemplene nedenfor som stammer fra det kinesiske selskapet Bytedance. Det er på tide å snakke KI-etikk med barna slik at falske videoer ikke benyttes til mobbing eller samfunnsskade.

Da kunstig intelligens ble tilgjengelig for folk flest for et par år siden, begynte man å telle fingre på bildene som ble produsert. Ofte viste KI-ene bilder av mennesker med seks og syv fingre, gjerne også forvridd til unaturlige posisjoner. Ved å lete etter slike feil, kunne man avsløre KI-bilder ganske lett.

Men nå trenger kunstig intelligens bare et enkelt bilde av deg, og vips, så er bildet gjort om til en svært troverdig video der du fremfører et budskap som du kanskje ikke står inne for. Det er noen ganger nesten umulig å se at filmen er falsk.

Snakk KI-etikk med barna

Halvparten av nordmenn har nå brukt kunstig intelligens, ifølge en undersøkelse fra Deloitte. Det blir stadig enklere å lage falske bilder og videoer, dette kan bli brukt til mobbing blant barn og unge. Ta stilling til om det er greit eller ikke å lage falske videoer av sine venner eller av offentlige personer og be barnet ditt følge din konklusjon.

Bitte små tegn

Denne gangen er det selskapet Bytedance fra Kina som viser eksempler på hva deres avanserte Omnihuman-1 kan produsere. Filmene ser svært ekte ut og man har bare brukt et enkelt bilde som utgangspunkt. Studerer du filmene svært nøye, kan du klare å finne hint om at de er KI-produsert. Se på smykket til damen i handlevognen, det dingler opp og ned som om det var en del av tegningen på t-skjorten. Det ser i alle fall noe rart ut. Selve tegningen på t-skjorten ser ekte ut «på avstand», men mistanken om KI gror når man setter filmen på pause. Og hvorfor er det umulig å lese navnet på brusflasken? Uansett er hintene så små at man ikke ser dem når slike filmer farer forbi i sosiale medier. KI-filmene ser mer ekte ut en noen gang.

I et annet eksempel er det tydelig KI-feil med strengene på en gitar, men det kan hende at den feilen lå i bildet som var utgangspunkt for filmen. Youtube-filmen nedenfor er fra en youtuber som følger med på utviklingen av kunstig intelligens, der ser du eksempler fra Omnihuman-1.

Egne KI-lover?

EU har allerede egne lover for kunstig intelligens, flere er på vei. Er dette nok, eller er det behov for ytterligere lover? Her er noen eksempler på hva norske politikere kan vurdere:

- Forbud mot bruk av en persons bilde eller stemme til falske innslag uten samtykke.

- Forbud mot ondsinnet bruk av falske videoer, som kan spre frykt, skade selskaper, spre rykter, benyttes til utpressing og lignende.

- Plikt til å merke syntetisk innhold.

- Plattformplikt til å lete etter syntestiske innslag.

- Straff mot falske videoer som kan påvirke valg.

- Rett til erstatning fra dem som lager falsk video om deg.

- Regler om hva slags videoer som kan benyttes i rettssaker.

- Lovpålagt vannmerking eller sporbarhet fra KI-er som produserer bilder og videoer.

- Mulige unntak for underholdningsbransjen.

- Bruk av KI i skolen.