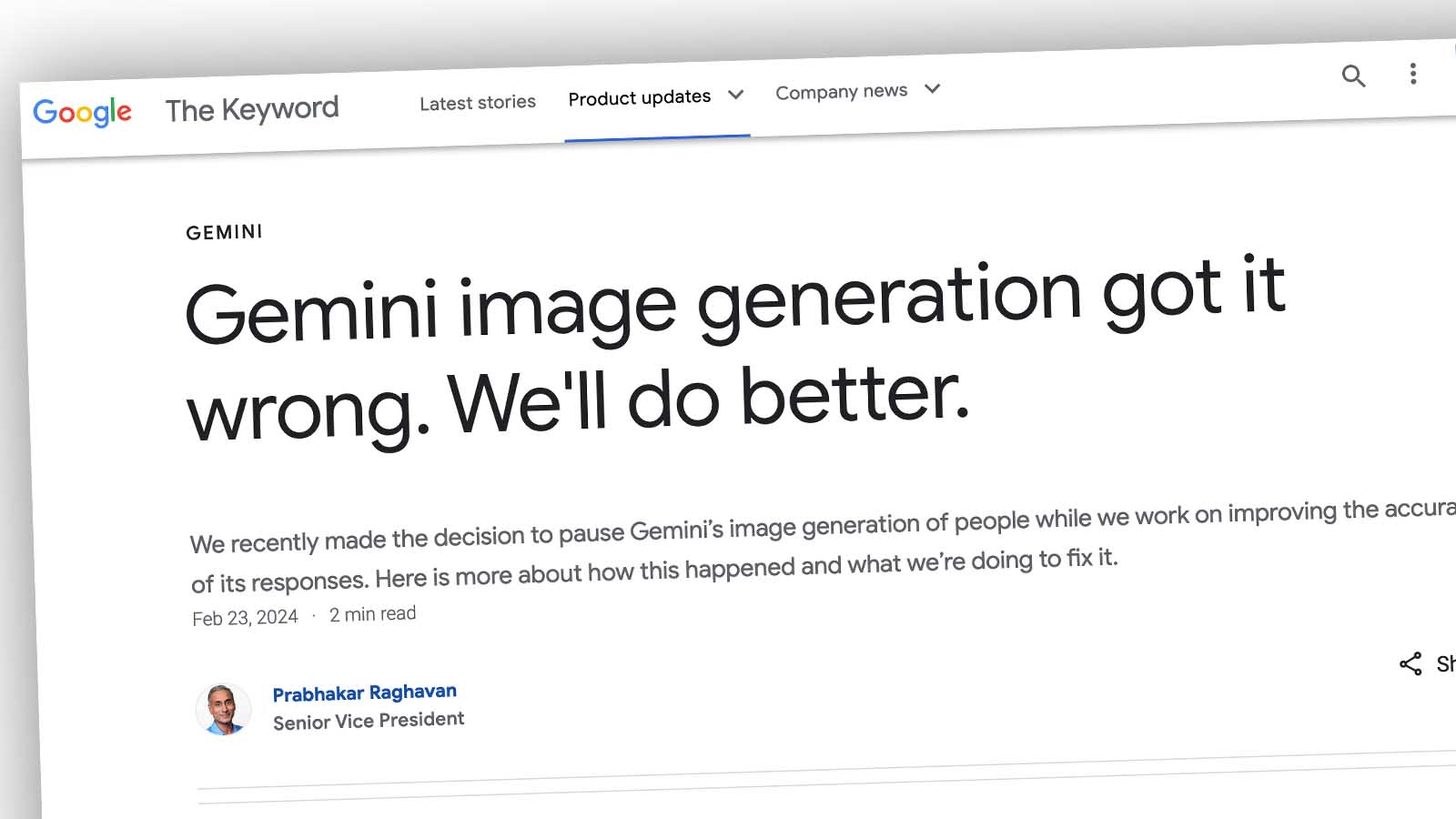

Google Gemini innrømmer bildefeil og har stengt AI-en

Google har midlertidig stengt sin tre uker gamle kunstige intelligens som lager bilder. Grunnen er at den overkompenserer for etnisitet og kjønn.

Google har en kunstig intelligens som kan skape bilder. Utviklerne ville gjerne forhindre at AI-en ble indirekte rasistisk eller kjønnsdiskriminerende.

Man vet jo fra før at AI-er kan være diskriminerende. For eksempel ChatGPT vil gjerne at sykepleiere skal være kvinner og leger skal være menn. Dette skyldes at AI-er er preget av hva de har lest på nettet.

Google programmerte derfor sin bilde-AI til å vise personer med ulike hudfarger og ulike kjønn i bildene.

Men så begynte folk å reagere på bilder hvor dette edle målet førte til misvisende bilder.

Kunstig intelligens trodde at paven kan være en kvinne

Når man for eksempel ba AI-en lage bilder fra en ishockey-turnering, viste den kvinner og menn på samme lag på banen.

Når man ba AI-en lage bilde med nazi-soldater fra andre verdenskrig, viste den soldater med mange ulike etnisiteter.

AI-en nektet i en del tilfeller også å lage bilder av mennesker med lys hudfarge. Den var for eksempel villig til å lage bilder av «black people smiling to each other», men ikke vilig til å lage bilder av «white people smiling to each other», ifølge tester som folk har delt på internett.

Når folk ba AI-en vise et historisk korrekt bilde av en britisk konge fra middelalderen, eller bilde av vikinger, produserte AI-en bilder av personer med mørk hudfarge.

Når folk ba Gemini vise bilder av en pave, viste den ofte bilder av en kvinne. Men i følge katolsk skikk kan ikke kvinner være pave.

Når folk ba AI-en vise bilder av greske filosofer, svarte den med å vise bilder av mennesker av ulike etnisiteter, for eksempel en mann som ligner den amerikanske urbefolkningen, sittende blandt greske søyler.

Google beklager feilen

Det kom så mange klager på internett at etter tre uker stengte derfor Google muligheten for å vise mennesker i AI-bilder, frem til utviklerne har reparert feilen og kodet AI-en med nye instrukser.

Google skriver på sine nettsider: «Some of the images generated are inaccurate or even offensive. We’re grateful for users’ feedback and are sorry the feature didn’t work well. We’ve acknowledged the mistake and temporarily paused image generation of people in Gemini while we work on an improved version.»

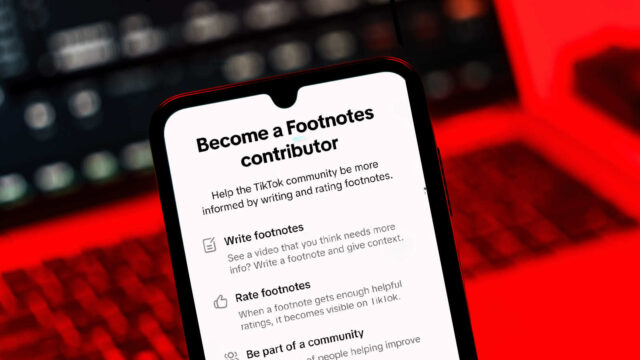

Skolene bør sikre at AI-en holder mål før elevene tar teknologien i bruk

Fremdeles er altså kunstig intelligens en umoden teknologi. Hver enkelt AI er også preget av de instruksjonene som utviklerne gir den.

Barnevakten mener at før skolene lar elevene benytte AI i klasserommet, må AI-en testes av en nøytral part, slik at foreldre, lærere og elever kan kjenne AI-ens kvalitet og etikk. AI-er med lav kvalitet bør holdes unna klasserommene.