Tiktoks algoritmer kan pushe negative videoer for barn

Hvilken risiko er det for at algoritmene sender barna inn i en spiral med stadig flere negative videoer? En undersøkelse fra Australia gir en del svar.

Den ideelle organisasjonen Reset Australia klarte med noen tekniske grep å følge datastrømmen inn og ut av Tiktok-appen. Man fant da ut hva som sankes inn av informasjon fra brukerne. I tillegg testet man hvor raskt algoritmene kan styre brukerne til å se upassende eller andre negative videoer.

Klarte å se hva som foregår under panseret i Tiktok-appen

Undersøkelsen ble gjort sommeren 2021 i samarbeid med journalisten Matthias Eberl fra Tyskland. Appen ble lurt til å sende data til en server som man selv hadde kontroll på, man kunne altså se hva som ble lastet opp eller ned.

Noen funn:

- Det var nesten ingen forskjell på dataflyten enten man var 13 år eller 30 år.

- Tiktok sendte data til Appsflyer som er kjent for å overvåke hvilke annonser du klikker på.

- Tiktok lot Facebook få vite at du benytter Tiktok-appen.

- Tiktok lot andre selskaper bygge personprofiler av brukerne.

- Jevnlig sendte Tiktok videre noe som kalles «Android Advertiser ID» som er like personlig som ditt telefonnummer. Din oppførsel i Tiktok ble altså sendt videre til andre apper. Det betyr at andre selskaper kan samle data om deg fra ulike apper som du har innstallert og som har fått samme Advertiser ID i din telefon. Slik kan andre selskaper enn Tiktok lage en samlet profil over deg, med data fra ulike apper.

- Tiktok kunne overvåke brukerne uten at de hadde opprettet Tiktok-konto. «Android Advertising ID» ble av Tiktok samlet inn etter at appen var lastet ned, men før brukeren hadde opprettet konto. Og det skjedde uten å be om tillatelse.

- Man fant også ut at hvis du deler noens Tiktok-video, følger din ID med i lenken.

- Så et lyspunkt: I denne undersøkelsen valgte testbrukerne å skru av lokasjonsdata, og her fulgte Tiktok opp og var potte tett. Det eneste som ble lekket videre, var tidssone.

Hvor raskt kan barna havne i en negativ algoritmespiral?

For å være sikker på at man startet med blanke ark i undersøkelsen, utstyrte man fire telefoner med helt nye simkort.

Så testet man telefonene med å vise interesse for ulike temaer inne i Tiktok-appen, for å se hvordan Tiktok-algoritmene endret seg.

De fire temaene som ble testet:

- Negativitet om etnisitet

- Negativitet om kjønn

- Misledende informasjon om korona eller vaksiner

- Vektnedgang og dietter

Man opprettet så en Tiktok-konto på hver telefon og oppga at brukeren var ei jente på 13 år.

I denne testen kikket man først på 30-35 Tiktok-videoer. Hvis videoene var upassende for en trettenåring, eller i grenseland for upassende, klikket man «like» for vise at man likte innslaget. Med upassende innslag mente man for eksempel at kvinner ble fremstilt mer negativt enn menn, eller motsatt.

Man søkte så tre ganger etter noe negativt.

Målet var å finne ut hvor raskt appen kan lede et barn inn i en løype med negative videoer. I denne testen søkte man ikke etter positive temaer. Hadde man gjort det, ville resultatet vært annerledes. Men uansett kan man stille spørsmål om hvorfor Tiktok ikke tok bedre hensyn til alderen til brukeren.

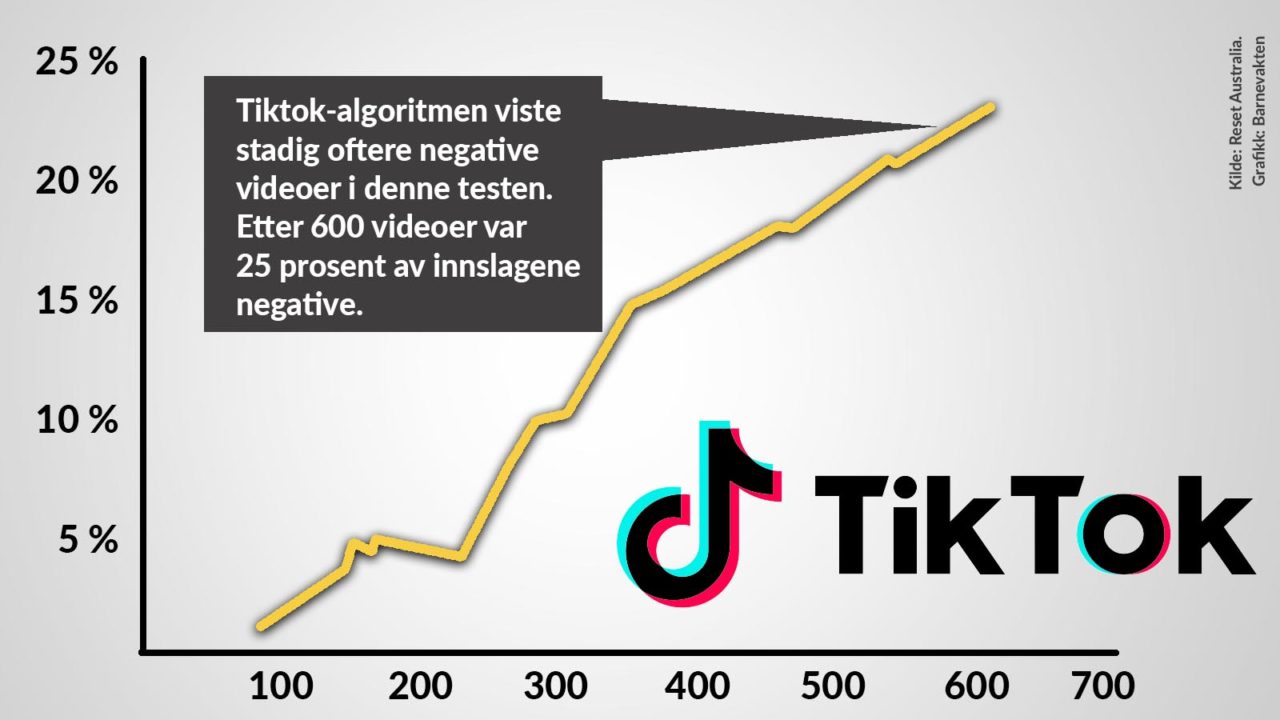

Etter de innledende tre negative søkene begynte algoritmene å vise én negativ video for hver tiende video som ble vist. Ganske raskt reagerte altså algoritmene og de tok ikke hensyn til barnets alder.

Andelen negative videoer økte til 25 prosent etter nesten fem timers bruk av appen. Men det var etter at testbrukeren bevisst hadde gitt like til en rekke med negative videoer som ble vist frem. Man må altså være klar over at denne testen er rigget for å provosere frem negative videoer.

Undersøkelsen stanset etter omkring 650 videoer. Da lå det an til at etter 2500 videoer ville samtlige videoer være negative, men dette ble ikke sjekket. I praksis vil neppe samtlige videoer være negative, for normalt vil en trettenåring ønske å se også positive videoer, og algoritmene vil rette seg etter det.

Men det undersøkelsen avslørte, er at algoritmene til Tiktok ikke tok nok hensyn til barnets alder. Dersom et barn for eksempel viser interesse for videoer som er misledende om korona, vil Tiktok gi barnet flere misledende videoer.

Denne undersøkelsen viste for øvrig at algoritmene oppførte seg annerledes ved temaet slanking enn ved de andre temaene som ble testet. Ved slanking var algoritmene snillere og viste ikke trettenåringen massevis med slankevideoer selv om man søkte etter slike videoer. Det kan derfor hende at Tiktok har lagt inn et filter i algoritmene der.

Rapporten fra Reset Australia finner du her.

Les også:

- Barnevakten testet hvordan det var å være ei jente på 13 år som laster ned Instagram-appen. Det tok ikke lang tid før vi fikk tilsendt pornolenker. En bevisst holdning fra foreldre og barn til innstillingene i appen kan hindre dette. Men vår test viste at Instagram fremdeles har hull når det gjelder å beskytte barn.

- Barnevaktens startside om Tiktok.

- Barnevaktens startside om algoritmer

Tips og råd hver uke, pluss tilgang til webinarer og plussartikler: Bli medlem av Barnevakten.

Lærere, her er undervisningsressurser om nettvett.