Kunstig intelligens diskriminerer kvinner på nettet

Her er enda noe mer du kan lære barna om nettet: Dataprogrammer kan diskriminere uten at det er gjort med vilje av programutviklerne.

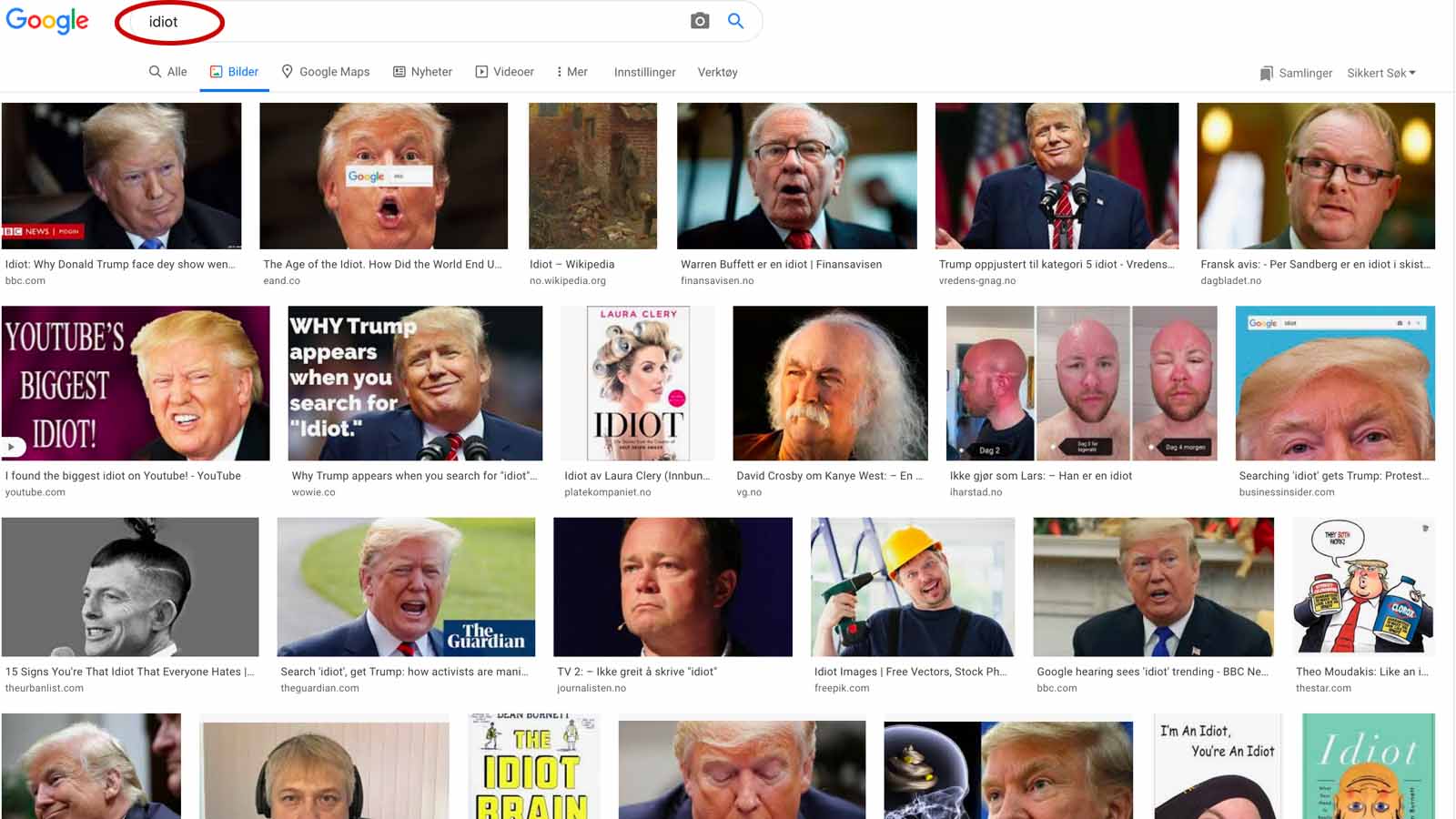

Mye av det vi søker frem på nettet er styrt av hvilke ord som den enkelte aktør har brukt i overskifter, bildefiler og lignende. Søker man etter «idiot» i søkemotoren Duckduckgo, kommer derfor Obama opp som treff nummer to. Bildefilen har nemlig dette navnet:

7a1fea014bce750ea3eafddc5054d27d–definition-of-idiot-wake-up.jpg

Så enkel er altså programkoden for søkemotoren, den leser ordene i bildefilen, og vips, så vises Obama som et treff. Vel, det er også flere andre parametre som teller med før et bilde havner på de øverste plassene.

Men de samme prinsippene gjelder også for Google. Søker du etter «idiot», får du frem mange bilder av Trump, bare fordi ordet idiot står et eller annet sted på nettsiden der bildet er lagt ut:

Google har mange parametre som vektes ulikt for å rangere søketreff. I bildet over ser du at BBC er første treff, det er fordi BBC er en stor og seriøs aktør, det vektlegges høyt av Google. Når BBC har ordet «idiot» i overskriften, da anses det som et bedre treff enn om du har skrevet det på din blogg som leses av noen hundre personer.

På en annen maskin som vi testet med bildesøket «idiot», var det et bilde fra en Wikipedia-artikkel som landet øverst i trefflisten, også Wikipedia anses av Google som en seriøs aktør. På en tredje maskin kom Wikipedia som nummer én og BBC som nummer tre. Mellom de to snek det seg inn et satirisk nettsted, det er ganske sikkert mange som har lenket til den nettsiden, og da tolker Googles programmer det til at nettsiden er viktig og fortjener å komme høyt opp i søk.

Men i utgangspunktet er søkemotorene uansett avhengige av hva hver aktør har brukt av ord på sine nettsider. Her spiller kultur inn. Er det vanlig å omtale utseendet til kvinner, men ikke utseendet til menn, da er nettopp det utgangspunktet for Google som leser nettsider og gir deg søketreff.

Følgefeil fører til automatisk diskriminering

I tillegg til søkemotorer finnes bildegjenkjenningsprogrammer. Utviklerne mater programmene med bilder som har stikkord knyttet til seg, og etter en opplæringsperiode klarer dataprogrammet å kjenne igjen hva som er fotografert, uten å få hjelp av stikkord som mennesker har lagt inn.

Når programmet er ferdig med opplæringen, kan det selv sette stikkord på bilder. På et bilde av Obama vil programmet kanskje kjenne igjen formen på et slips, formen på et flagg som henger i bakgrunnen og at Obama er et menneske. Dermed setter programmet dette som stikkord: Slips, flagg, menneske.

En bedrift som har et kartotek med haugevis av bilder vil leie inn slike bildegjenkjenningsprogrammer for å slippe at ansatte må sitte timevis foran skjermen og manuelt legge inn stikkord på hvert eneste foto.

Når noen skal søke etter bilder av slips, eller flagg, vil dermed bildet av Obama dukke opp, hvis det ligger i kartoteket.

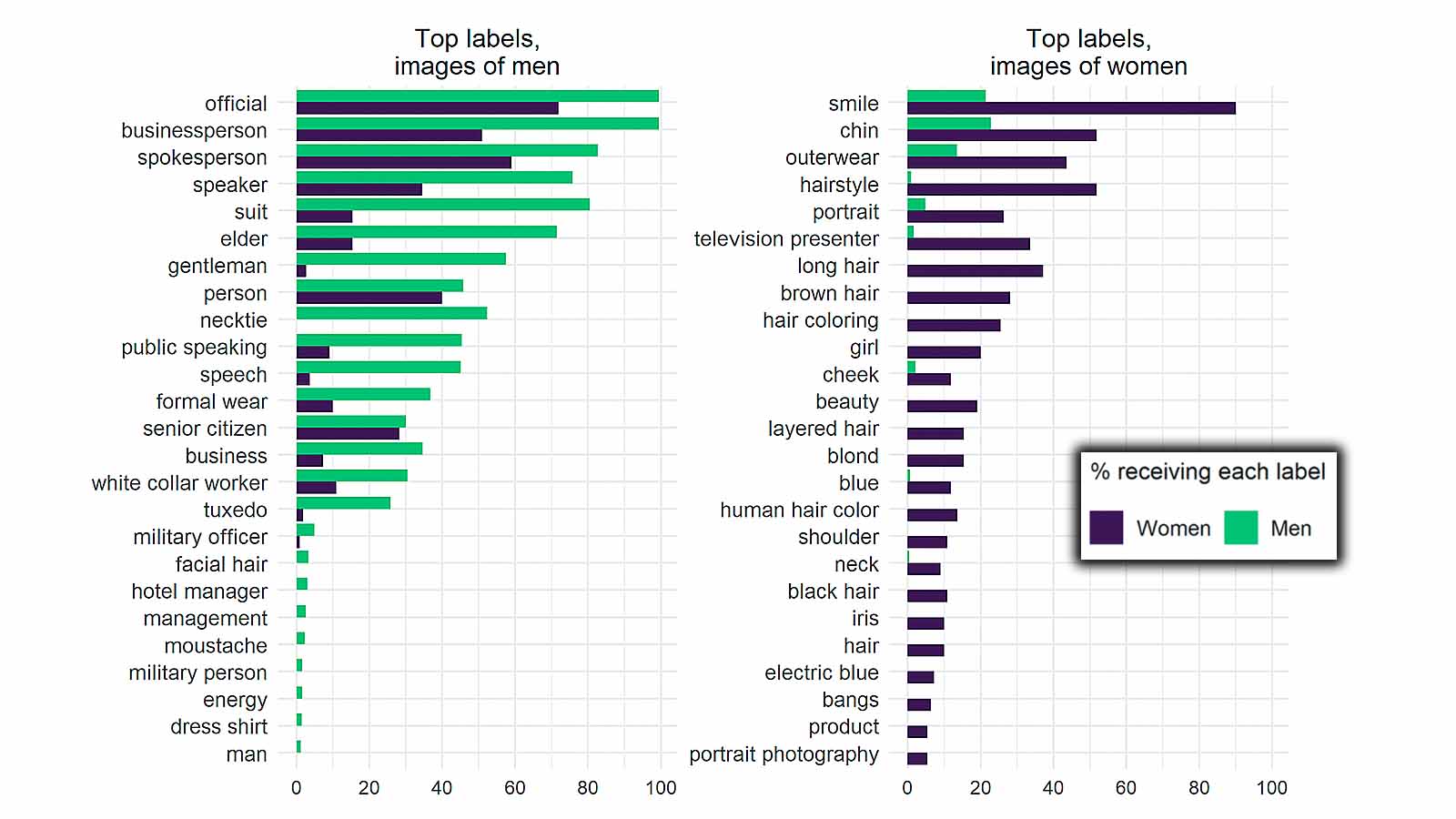

I en amerikansk undersøkelse benyttet forskerne tre slike programmer fra Google (GCV), Microsoft og Amazon for å bildekategorisere politikere i den amerikanske kongressen. På alle tre plattformene mener forskerne å ha beviser for at programmene forskjellsbehandler kvinner og menn.

Stikkord med status ble knyttet til mennene, selv om kongressmedlemmene har samme jobb. Kvinnelige politikere ble kalt «jente» i 20 prosent av tilfellene. Mennene ble derimot kalt «gentleman» i nesten 60 prosent av tilfellene.

80 prosent av kvinnelige politikere fikk stikkordet «smil» festet til bildet automatisk, mens kun 20 prosent av de mannlige politikerne fikk dette stikkordet påklistret av programmet. Menn ble kalt forretningsmenn, mens stikkordene på kvinnene handlet mest om hårfrisyrer eller lignende. Over 30 prosent av de kvinnelige toppolitikerne fikk stikkordet «programvert på TV», mens nesten ingen av mennene fikk dette stikkordet.

Dette er en form for følgefeil av hva som er lettest for programmene å kjenne igjen i bildene og hvilke stikkord som var knyttet til andre bilder i opplæringsperioden som gjenkjennelsesprogrammet måtte gjennom.

Bildet under viser hva som var de vanligste stikkordene som gjenkjennelsesprogrammet selv la inn på bilder av amerikanske politikere:

Når det var en kvinne avbildet, forsto Google GCV det i bare 26 prosent av tilfellene. Når det var en mann i bildet, forsto Google GCV det i 45 prosent av tilfellene. Programmene kjenner altså lettere igjen menn. Hvem vet, kanskje er det bruken av slips som er utslagsgivende. Men også dette kan bety en diskriminerende følgefeil. La oss si at du søker etter kvinnelige forretningsfolk. Av 100 forretningskvinner, finner du bare 26 av dem. Av 100 forretningsmenn, finner du 45 av dem. Dermed er det større sannsynlighet for at du tilbyr en mann en forretningsavtale.

I land der man ikke bryr seg om personvern, samler man inn mange opplysninger om befolkningen. Statistikk kan hentes ut og selges billig til bedrifter som holder til i land som er opptatt av personvern og der slik statistikk ikke er mulig å kjøpe. Det kan bety at bildegjenkjennelsesprogrammer eller andre programmer som innholder statistikk over økonomi eller helse, kan smittes av kulturer fra utlandet, og det kan være kulturer som undertrykker kvinner, minoriteter, religioner eller politiske syn.

Lær barna å være bevisste brukere av nettet

Algoritmer, kunstig intelligens og markedskrefter er vanskelige temaer og store krefter, men du kan lære barna noen holdninger og litt digitalt selvforsvar. Barn og voksne må lære å være bevisste brukere av nettet. Når barna søker på nettet, spør da om de vet hvorfor maskinen viser akkurat det bildet eller akkurat den artikkelen. Her er noen svar:

- Fordi noen vil selge deg noe.

- Fordi søkemotoren blir lurt av stikkordene som aviser og folk flest har hektet på det de publiserer.

- Fordi programmene med kunstig intelligens har fått feil opplæring.

- Fordi det finnes diskriminering i ulike samfunn og kulturer og dette smitter over på hva nettet viser.

- Fordi det som vises er påvirket av algoritmer, altså hva du har kikket på tidligere, hvor du bor eller om du er gutt eller jente.

For å motvirke dette, må hver enkelt av oss gå «manuelt» og bevisst til verks når vi søker og ikke bare la oss styre av automatikken i maskinen og programmene.

Be gjerne barna sammenligne sine søketreff, slik ser de at søk også er persontilpasset. En oppgave for de litt større barna kan være å forsøke å gjette hvorfor de fikk akkurat de søketreffene de fikk.

Noen tips

Les også

- Googles algoritmeetikk

- Unicef ønsker barnevennnlig kunstig intelligens (les et stykke ned i artikkelen)

- Tips og råd om nettvett hver uke, samt tilgang til webinarer om nettvett: Bli medlem av Barnevakten.Lærere, her er undervisningsressurser om nettvett.