Nå skal også Apple sjekke om folk har overgrepsbilder

En del skyleverandører sjekker om folk laster opp bilder av overgrep mot barn. Også Apple vil nå sjekke folks bilder som lastes opp til Icloud Photo.

Når du lagrer bilder i skyen, kan det hende at skyselskapet sjekker om bildene er overgrepsmateriale. For eksempel Google sjekker hva slags bilder folk laster opp på selskapets plattformer. Brukerkontoen slettes dersom Google oppdager overgrepsbilder, videre varsles organisasjonen NCMEC som så varsler politiet.

I USA er det en ideell organisasjon som heter «National center for missing and exploited children» (NCMEC). Denne organisasjonen har et stort arkiv over savnede barn. Arkivet inneholder også overgrepsbilder der barn er involvert, slike bilder kalles CSAM (Child Sexual Abuse Material), derfor kalles slike bilder CSAM-bilder.

Også Apple skal nå sjekke om folk laster opp overgrepsbilder. Så langt vi forstår, benytter Apple overgrepsarkiver fra minst to slike organisasjoner, og det aktuelle bildet må gi treff i begge arkivene før Apple reagerer.

Apple har tidligere lovet kundene at selskapet ikke skal snoke i deres filer. Når nå Apple skal sjekke om folk laster opp overgrepsmateriale, kan det oppfattes til å være er i strid med selskapets tidligere løfter, derfor har det vært noe kritikk mot Apple de siste ukene.

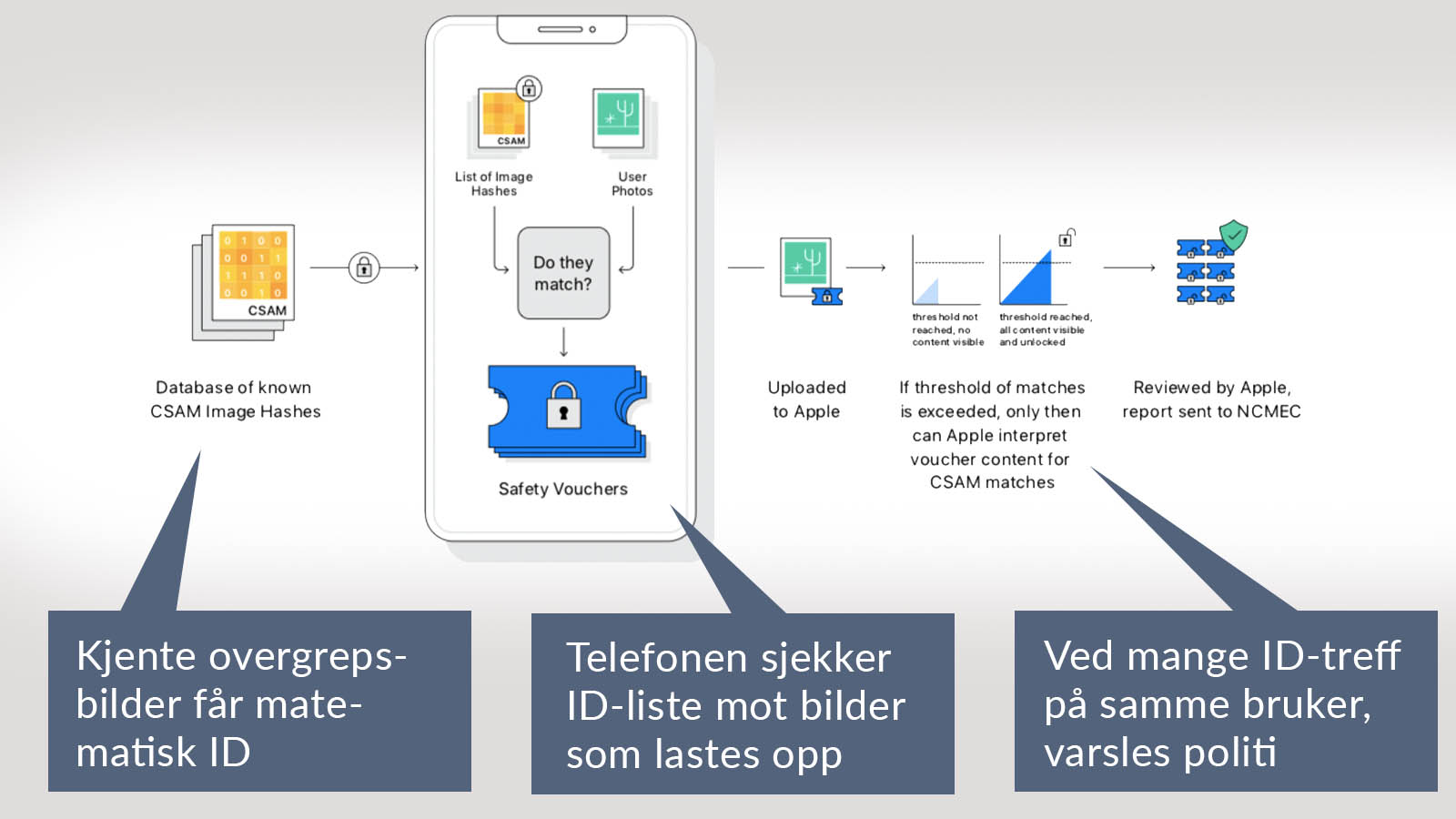

Det spesielle med Apples opplegg er at kontrollen starter allerede i brukerens telefon:

Bildets fingeravtrykk

De ideelle organisasjonene som har arkiver med overgrepsbilder, utstyrer hvert overgrepsbilde med en matematisk kode som forteller hvordan bildet er bygget opp. Man kan kanskje kalle det for bildets fingeravtrykk. Dette fingeravtrykket vil være mulig å oppdage selv om arkivet kun benytter en kopi av originalbildet som utgangspunkt og selv om de aktuelle bildene som skal sjekkes er en kopi av en kopi. Det hjelper ikke å beskjære bildet, endre fargene, rotere eller komprimere det.

Teknikken ligner på ansiktsgjenkjenning, for også ansiktsgjenkjenning bygger på matematikk etter å ha målt avstandene mellom øyne, ører, nese og lignende. Og selv om et ansiktsbilde beskjæres og roteres, klarer matematikken likevel å kjenne igjen ansiktet.

Sjekker bildene i telefonen, deretter i Icloud

Hvert overgrepsbilde som finnes i organisasjonenes databaser utstyres altså med en unik kode, en såkalt hash. Slik lages det en lang liste med unike koder for kjente overgrepsbilder, denne listen legger Apple inn i Iphonene. Når noen bruker telefonen sin til å laste opp et hvilket som helst bilde til skyen Icloud Photo, altså Apples bildesky, vil telefonen samtidig sjekke bildet mot overgrepslisten.

Blir det treff i telefonen, legger telefonen på et hemmelig filvedheng på bildet som brukeren laster opp til Icloud Photo.

Når bildet er lastet opp til Icloud Photo, skjer det først ingenting. Det er først når antall overgrepsbilder overskrider et bestemt antall, hos den samme brukeren, at Apple tar en manuell kikk på bildene.

Benytter du ikke skyen Icloud Photo, vil ikke bildene dine bli sjekket. Bilder som er kun lagret lokalt på telefonen, eller sendt til andre skyer, vil ikke bli sjekket.

Apple leser ikke noe mer ut av bildene dine enn selve overgrepskontrollen, for eksempel metadata blir ikke lest. Metadata kan være klokkeslett, lokasjonsdata, telefonmodell eller stikkord som du har knyttet til bildet.

Systemet tolker ikke hvert bilde slik man ofte mener med kunstig intelligens som teller opp hvor mye av bildet som er i hudfarge for eksempel og som lander på at «dette er en bil» og «dette er et tre». Systemet sjekker kun om oppbygningen (matematikken) er lik et av overgrepsbildene som ligger i arkivet.

Presist system

Systemet til Apple påstås å være svært presist, spesielt fordi man ikke går til aksjon hvis noen laster opp et par-tre overgrepsbilder. Det er først når det er treff blant la oss si 20-30 bilder, at alarmen går. Og da er man svært sikker på at det er snakk om overgrepsbilder, for systemet med fingeravtrykk kan kanskje ta feil én gang, men ikke 20 ganger på rad.

Muligheten for systemfeil er visstnok en til en billion. Likevel tar ansatte i Apple en manuell sjekk og kikker på bildene for å være helt sikker før man sier fra til NCMEC som tar saken videre til politiet. Så langt vi forstår, får brukeren ingen beskjed før eventuelt politiet dukker opp på døren.

Det er altså svært sjelden at ansatte i Apple kommer til å se folks bilder, man er nær 100 prosent sikre på at det er overgrepsbilder når man tar en manuell sjekk. Apple kikker altså ikke på andre bilder som folk har lastet opp. Men kritikere vil mene at Apple, og de andre skyselskapene, uansett ikke skal drive «privat politietterforskning». Kritikere er også engstelige for at Apple, og andre skyselskaper, vil fortsette med nye temaer senere for å avverge skattesnusk, terror, rasisme eller hva som helst annet som man gjerne vil bekjempe, og at til slutt blir folk massivt overvåket.

En annen kritikk mot systemet er at det kun sjekker kjente overgrepsbilder og ikke makter å avsløre ferske overgrepsbilder. Skal man avsløre ferske overgrepsbilder, må man i tilfelle benytte kunstig intelligens som kan tolke bildene på egen hånd og finne ut at «dette er en båt» og «dette er nakne mennesker» og så videre. Videre må det i tilfelle benyttes stort monn av manuell sjekk utført av mennesker i etterkant ved mistanke. Og da vil nok mange mene at deres privatliv blir invadert når ansatte skal sjekke mange av bildene deres som slett ikke er overgrepsbilder, men som er bilder fra stranden eller statuene i Vigelandsparken – eller er nakenbilder av kjæresten.

Også Google bekjemper overgrepsmateriale

For å kunne fjerne overgrepsmateriale på sine plattformer, bruker Google både teknologi og manuell evaluering. Teknologien går ut på både kunstig intelligens og hash-samsvar. Det betyr at Google ikke bare finner bilder som er kjent, men selskapet kan også finne også ferske overgrepsbilder som ikke har fått noen hash-kode. Google tilbyr denne teknologien gratis til selskaper som vil bekjempe overgrepsbilder der barn er involvert, det er beskrevet her.

Det betyr at Google gjør en kraftigere innsats enn Apple for å bekjempe overgep mot barn, samtidig er Apple mer forsiktige når det gjelder å undersøke folks filer.

Sladder nakenbilder i barnetelefoner

Nyheten om at Apple skal jakte overgrepsbilder kom samtidig med at Apple vil lansere en ny foreldreinnstilling i telefonene. Hvis et barn bruker en telefon fra Apple, vil telefonen sladde nakenbilder som andre sender til barnet. Dette virker kun i meldingstjenesten til Apple. Les mer om det her.

Oppdatering 6. september 2021: Apple utsetter opplegget der man skulle sjekke telefonene for overgepsmateriale, dette forteller nettstedet Journalisten.

Oppdatering 31. august 2022: En amerikansk pappa oppdaget at sønnens penis var betent og sendte et bilde til kona, via Googles sky, hun videresendte til legen som så ordnet antibiotika til gutten. Dette medisinske bildet ble fanget opp av Googles kunstige intelligens, selskapet varslet politiet. Telefonen ble undersøkt av politiet og saken ble avsluttet. Men pappaens Google-konto ble stengt av Google. Dermed mistet han flere år med bilder, videoer, e-poster og mye annet. Dette skriver Din Side.

Oppdatering 2. oktober 2023: Foreningen National center for missing and exploited children kan være til hjelp dersom nakenbilder av barnet ditt er blitt spredd. Da kan teknikken med digitalt fingeravtrykk benyttes for å søke etter bildene i flere av de store sosiale mediene. Les mer.

Les også: